- WIADOMOŚCI

Kosmiczne centra danych: wybujała fantazja czy realna potrzeba?

Wielkie kosmiczne konstrukcje rozciągające się na kilometry mają rozwiązać narastające problemy ziemskich centrów danych.

Autor. Starcloud

Trwający boom na AI napędza budowę kolejnych centrów danych z dziesiątkami tysięcy zaawansowanych chipów, potrzebnych do trenowania coraz wydajniejszych dużych modeli językowych (LLM), takich jak ChatGPT, DeepSeek czy Mistral.

Nieustannie rosnący popyt na moc obliczeniową ma przełożyć się globalnie na 7 bilionów dolarów inwestycji w tę krytyczną infrastrukturę do 2030 roku. Wraz z tysiącami nowych centrów danych coraz dotkliwiej ujawnią się ograniczenia energetyczne, wodne i przestrzenne.

Popyt na energię elektryczną generowany przez centra danych ma się podwoić do 2030 r. i dorównać dzisiejszemu zużyciu całej Japonii. Już teraz w USA, gdzie jest ich najwięcej, odpowiadają za ponad 4% krajowej konsumpcji energii, a udział ten będzie dalej rosnąć.

To rodzi pytanie, czy produkcja energii zdoła nadążyć za ich rosnącym apetytem, skoro w USA centra danych mogą odpowiadać za niemal połowę przyrostu zapotrzebowania na prąd do 2030 r. Niepokój budzi też presja na sieć elektroenergetyczną oraz fakt, że dziś ponad połowa energii zużywanej przez centra danych pochodzi z paliw kopalnych.

Poza ogromnym zapotrzebowaniem na energię centra danych zużywają także abstrakcyjne ilości wody do chłodzenia rozgrzanych procesorów. Największe mogą pobierać do 19 mln litrów dziennie, czyli ok. 7 mld litrów rocznie – tyle, ile zużywa średnie 50-tysięczne miasto. W regionach dotkniętych niedoborem wody taka infrastruktura może dodatkowo pogłębiać problemy z jej dostępnością.

Według szacunków już w przyszłym roku same centra danych trenujące modele AI mogą zużyć łącznie 6,5 biliona litrów wody, czyli równowartość 2,6 mln basenów olimpijskich. Dlatego istnieje duże ryzyko, że ich dalsza ekspansja będzie dokładać się do narastającego kryzysu wodnego.

W XVIII wieku brytyjski ekonomista Thomas Malthus pisał o ograniczonej ilości ziemi jako fundamentalnej barierze wzrostu rolnictwa. Dziś mógłby ostrzegać przed podobnym naturalnym ograniczeniem dla długofalowego rozwoju AI i centrów danych. Nawet jeśli gruntu jeszcze nie brakuje, ich rosnące hale już teraz zajmują cenną przestrzeń i dominują krajobraz.

Kosmiczne centra danych – nowa obietnica amerykańskiego Big Tech

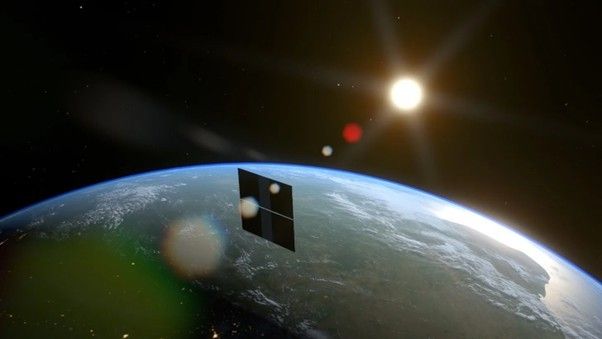

Wobec tych ziemskich ograniczeń coraz częściej podnosi się pomysł przeniesienia centrów danych w kosmos. Tam miałyby być zasilane energią słoneczną, chłodzone w próżni i niemal nieograniczone przestrzenią. Najbardziej zainteresowane tą wizją są amerykańskie giganty technologiczne rozwijające AI, które w ostatnim czasie zainwestowały w start-upy obiecujące szybko ją urzeczywistnić.

Wśród nich wyróżnia się wspierany przez Nvidię startup Starcloud, który w listopadzie ubiegłego roku umieścił na orbicie swoją pierwszą komercyjną satelitę z procesorem Nvidia H100. W grudniu firma ogłosiła, że z jego pomocą przeprowadziła trening jednego z modeli GPT od OpenAI, co miałoby być pierwszym takim osiągnięciem.

Jej plany są jednak znacznie ambitniejsze i obejmują budowę na orbicie wielokilometrowych megakonstrukcji z modułowych kontenerów wypełnionych procesorami graficznymi, zasilanych rozległymi panelami słonecznymi. Prosta, modularna architektura ma pozwolić na montaż na orbicie, szybkie skalowanie oraz łatwą wymianę elementów.

Kluczem do sukcesu ma być ekonomia: na papierze rozwiązanie ma być o rząd wielkości tańsze od ziemskich odpowiedników. Startup szacuje, że koszt klastra o mocy 40 MW w horyzoncie 10 lat wyniesie niespełna 8 mln dolarów, podczas gdy dla konwencjonalnego centrum średnio to aż 170 mln.

Różnica ma wynikać głównie z niskiego, w dużej mierze jednorazowego kosztu energii: praktycznie ogranicza się on do produkcji paneli słonecznych i ich wyniesienia na orbitę. Potem pozyskiwanie prądu staje się niemal bezkosztowe. Startup chce użyć ultracienkich, silikonowych paneli, które można zwinąć przed startem. Do zasilenia centrum danych o mocy 5 MW ich łączna powierzchnia miałaby sięgać ok. 4 na 4 km.

Dlatego tak kluczowa jest ich ciągła ekspozycja na Słońce. Ma ją zapewnić umieszczenie konstrukcji na niskiej orbicie okołoziemskiej (LEO), konkretnie na orbitach słoneczno-synchronicznych typu „dawn–dusk” (dawn–dusk sun-synchronous orbits, SSO). W dalszej perspektywie jeszcze atrakcyjniejsza może być podobna orbita wokół Księżyca, wolna od satelitów i kosmicznych śmieci.

O takim projekcie i jego opłacalności można dziś mówić głównie dzięki rewolucji w kosztach wynoszenia ładunków na orbitę, napędzanej przez rakiety wielokrotnego użytku. Starcloud chce korzystać z wciąż rozwijanego Starshipa, który ma obniżyć cenę wyniesienia 100 ton ładunku do ok. 5 mln dolarów.

Amerykański startup nie jest sam, a jego koncepcja nie jest jedyna. Przykładem tego jest ogłoszony w listopadzie 2025 roku przez Google projekt Suncatcher. Firma chce w jego ramach zbudować konstelację satelitów zasilanych energią słoneczną i wyposażonych w procesory Google, które miałyby wspierać uczenie maszynowe jej modeli AI.

Konstelacja ma tworzyć obracający się „rój” o promieniu około jednego kilometra, w którym satelity dzieliłoby zaledwie 100–200 metrów. Taka bliskość miałaby umożliwić spięcie ich w jedną sieć dzięki rozwijanym łączom optycznym o bardzo wysokiej przepustowości.

Niezbędna technologia ma zostać zademonstrowana już na początku przyszłego roku, gdy na orbitę trafią dwa prototypy satelitów, które przetestują pracę procesorów w warunkach kosmicznych oraz zdolność satelitów do utrzymania stałego połączenia.

Koncepcją kosmicznych centrów danych interesują się też dwaj zaciekli rywale w sektorze kosmicznym: Elon Musk z SpaceX oraz Jeff Bezos z Blue Origin. Musk chce wykorzystać do ich budowy zmodyfikowaną wersję Starlinka V3, a środki na ten projekt ma według doniesień zapewnić planowany debiut giełdowy firmy. Bezos również wierzy w tę koncepcję; Blue Origin pracuje nad potrzebnymi technologiami od ponad roku.

Realizowane projekty i głośne zapowiedzi windują wycenę rodzącego się sektora: według prognoz w 2029 roku ma on być wart 1,77 mld dolarów, a do 2035 roku urosnąć do 39,09 mld.

Nowy kosmiczny wyścig? Pekin chce przewodzić

Na orbicie znajduje się już pierwszych 12 satelitów chińskiej „trójciałowej konstelacji obliczeniowej”, nawiązującej do słynnego problemu trzech ciał, określanej jako pierwszy orbitalny „superkomputer”. Docelowo ten rozproszony system ma liczyć 2800 satelitów komunikujących się za pomocą superszybkich łączy laserowych.

Tymczasem Europa, mimo silnej bazy technologiczno-instytucjonalnej, może nie włączyć się realnie do tego wyścigu. W listopadowym raporcie Europejski Instytut Polityki Kosmicznej ostrzegł, że bez konkretnego planu rozwoju kluczowych technologii i ich szybkiej komercjalizacji Europie grozi pozostanie w tyle za dwiema potęgami.

Kosmiczna weryfikacja: wyzwania i ryzyka

To powiedziawszy, świetlana przyszłość kosmicznych centrów danych wciąż nie jest przesądzona. Wielu wskazuje na wyzwania i problemy, które w praktyce mogą okazać się trudniejsze do pokonania, niż chcieliby ich główni propagatorzy.

Obietnica rentowności kosmicznych centrów danych opiera się na dalszym spadku kosztów wynoszenia ładunków na orbitę. Choć te spadły już o ponad 95%, do ok. 1500 dolarów za kilogram, firmy takie jak Starcloud liczą na zejście do 50 dolarów za kg, czyli kolejne 95%. To, czy tak się stanie, zależy w dużej mierze od rozwoju Starshipa: jego dalszych opóźnień, niezawodności, wejścia do eksploatacji oraz częstotliwości lotów.

Nie można też pomijać promieniowania kosmicznego, zabójczego dla zaawansowanej elektroniki. Potencjalne rozwiązania typu radiation-hardened obejmują izolację, gęste osłony oraz zabezpieczenia logiczne, takie jak pamięć z korekcją błędów (ECC) czy potrójne powielanie układów (TMR). Problem w tym, że technologie „rad-hard” wciąż nie nadążają za tempem rozwoju procesorów, co może wymagać dużych nakładów badawczo-rozwojowych w następnych latach.

Kolejne wyzwania techniczne to przesył danych i ograniczenie ryzyka ich utraty. Mimo wysokiej prędkości i przepustowości łącza optyczne będą musiały stać się jeszcze precyzyjniejsze i bardziej niezawodne. Potrzebne są też nowe metody zabezpieczania i odzyskiwania danych, bo budowa kopii zapasowych na Ziemi lub dodatkowych satelitów podważałaby samą ekonomię kosmicznych centrów danych.

Zasilanie też nie jest pozbawione problemów, bo instalacje słoneczne musiałyby rosnąć wraz z mocą centrum danych do kolosalnych rozmiarów. Ich obecność może utrudniać pracę astronomom i prowadzić do dalszego zaśmiecania orbity, nie wspominając o skutkach ewentualnej destrukcji tak wielkich struktur na orbicie. Szczególnie kontrowersyjna jest konstelacja proponowana przez Google ze względu na niewielkie odległości między satelitami. Mimo zapewnień o matematycznej stabilności układu krytycy ostrzegają, że jeden błąd mógłby uruchomić niekontrolowaną kaskadę kolizji.

Nareszcie liczba startów rakiet potrzebnych do budowy i utrzymania takich systemów mogłaby sięgnąć tysięcy rocznie, co mogłoby zniweczyć ich potencjalne korzyści środowiskowe, zwłaszcza jeśli ziemskie centra danych przejdą na czyste źródła energii.

Przyszłość: Ziemia czy kosmos?

Kosmiczne centra danych już dziś stają się rzeczywistością dzięki wielkim pieniądzom, postępowi technologicznemu i realnej potrzebie. Wciąż jednak opierają się na wielu optymistycznych założeniach i wymagają przełomów, zanim staną się opłacalną, skalowalną alternatywą dla ziemskich instalacji.

Nie można przy tym wykluczyć, że te drugie mogą w przyszłości zostać ulepszone do takiego stopnia, że przeniesienie ich na orbitę stanie się mniej palącą koniecznością, a jedynie opcją. W takim scenariuszu najbliższe lata mogą okazać się kluczowe, otwierając krótkie okno na przekucie tej idei w rzeczywistość i stworzenie nowego sektora, który przyniesie istotne korzyści gospodarce kosmicznej.